NLP2024 1日目

適宜加筆修正します

今年の個人目標

キーワードを集める

アイデアの評価手法を知る

評価実験で使われるデータセットを知る

チュートリアル1(東工大 岡崎先生)

『自然言語処理の基礎』

自然言語処理の発展(深層学習導入前)

機械翻訳の草創期

翻訳は暗号解読ではないか?

未知の言語で書かれた文字列を復号するというアイデア

この着眼点凄すぎる

しかし実際には言葉の境界はあまりにも曖昧で難しかったとのこと

タイムライン

マルコフ連鎖

Zipfの法則 1932

人工ニューロン 1943, 1958

n-gram 1951

長年主流だったやつ。シャロンの論文。bi-gram tri-gram

分布仮設 1954

のちのGPTにつながる

統辞構造論 1957

自動要約 1958

この頃ですでに「文献が多くて読みきれない」という課題があった

今こうして振り返れるのはおもしろい。論文に研究のモチベーションを書いておく意義がわかってきた

これらすべてC言語が生まれる前から取り組まれていた。この時代のパワーの凄さを感じとれる。

わかる。以前LLM関連の本を読みながらこの分野の年表を作っていて、同じように感激してた

機械翻訳に対する投資の加速と見直し

ALPAC報告書

一般的な翻訳の成功例が少なすぎたことや、人間が頑張って勉強すれば外国語の文献もいずれ読めるようになるだろうという見方

投資を打ち切ったほうがいいのでは?

一方で継続的に投資すべき分野もある

構文解析などの計算言語学

機械がが人間をアシストする翻訳

注釈付きコーパス、辞書の開発

言語学者による一貫したアノテーション

紛らわしい場合の判定方式もしっかり定められていた。事例付き。

質の高いアノテーションを作ろうと頑張った

徹底的に良質なものを作ってもらえていたことに感謝

翻訳ルールを事例から作れないか?

用例ベース機械翻訳

対訳事例から対応する英語の翻訳を取り出す

すべての入力の塊に対して適用する

文全体の出力を推定できる

機械学習の先駆け的なアイデアである

統計的機械翻訳

機械翻訳を確率モデルとして実現

対訳関係の推定

「ある単語が特定の単語に翻訳されやすい」

英単語の並びの自然さを求めるタスクとなる

基盤技術の発展がアプリケーションの発展になる

また一方でアプリケーションの課題から基盤技術の発展の余地が見つかる

この相互作用はそのとおりだと思う。アプリ作っている側として何か有益なフィードバックをできるようになりたい

Webの登場と自然言語処理での活用

Webコーパスの活用

Wikipedia、Wikidata

社会観察がネットからできる

情報洪水、情報爆発

大規模日本語n-gramデータベース

機械学習・分散学習

最大エントロピー法、SVM、条件付き確率場、オンライン学習

MapReduce 2004

分散並列学習 2009

大規模言語モデルの仕組み

入力の続きを予測する

単語列に続くべき単語を一つずつ予測する

予測した単語を末尾に追加して続きをやる

もっとも次に来るかを計算して求める

確率の最大値がわかればいい(だけ)

条件付き確率

単語ベクトル

ニューラルネットワークに埋め込む

埋め込み表現、Embedding

類義語は似ているベクトルを持つと期待でき、演繹による類推が可能

特徴エンジニアリングが不要になる

再帰型ニューラルネットワーク(RNN)

直前までの情報を表すベクトルと単語埋め込みを連結して、次元を調整

長くなると忘却しがち

→ これを解消できたのが注意機構

ニューラル言語のスケール則 2020

アーキテクチャによらない

パラメータ数、訓練データ数、計算量 のみによる

プロンプト

LLMに与えるテキスト(=プロンプト)を工夫すれば、言語モデルのアーキテクチャを変更せずにタスクを解ける

zero-shot

few-shot

未知のタスクの説明と解き方の例を連結したプロンプト

fine tuningよりは劣る

大規模言語モデル時代の自然言語処理研究

自然言語処理の「世界範囲」が広がる

コーパス < インターネット < 認知 < 身体性 < 社会性

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

まだこの辺カバーできてないよね? でもChatGPTは言語だけで”できてる感”はある?

なにすればいいの?

LLMを構築・改良する

活用する

関連しない研究も進める

未消化キーワード

Transformer

Attention is all you need論文

Googleブログで紹介されているアニメーションGIFのアーキテクチャ図は、専門家から見ると挙動をよく説明できている良い画像とのこと

これを理解できるようになりたい

Generative Pre-Training (GPT) 2018

GPT-3

QKV注意機構

query key value による注意機構

qベクトルにkey行列を作用(内積計算)させてvを求めて新たなqとする

定式化: Attention(Q,K,V)

クロス注意

自己注意

マスク付きの自己注意

推論時は自分よりも未来に位置する単語をattentionしてはいけない

後方からの重みをゼロにする行列をつくればいい

自己注意が代名詞の照応先を解消する

文の最後まで見ないとitの参照先が定まらない例でもうまくうごいてる

マルチヘッド注意機構

異なる観点で重みを計算できるように、複数の注意機構をもたせる

位置符号

残差結合

深いニューラルネットワークを学習するときに有用らし

ResNet

フィードフォワードネットワーク

興味深い話だった

学習したい関数の代わりにを考えて、を得る。のはよりも学習しやすいと仮定すると、なんかいい感じになるらしい

アーキテクチャ図を少し読めるようになった気がする

各層(コンポーネント?)ごとに明確な役割があるっぽいので一つずつ読み解いていけば良さそうだ

フィードフォワード層

記憶を蓄積しているのではないかと言われている

文脈長の拡張

Sparse Transformer 2019

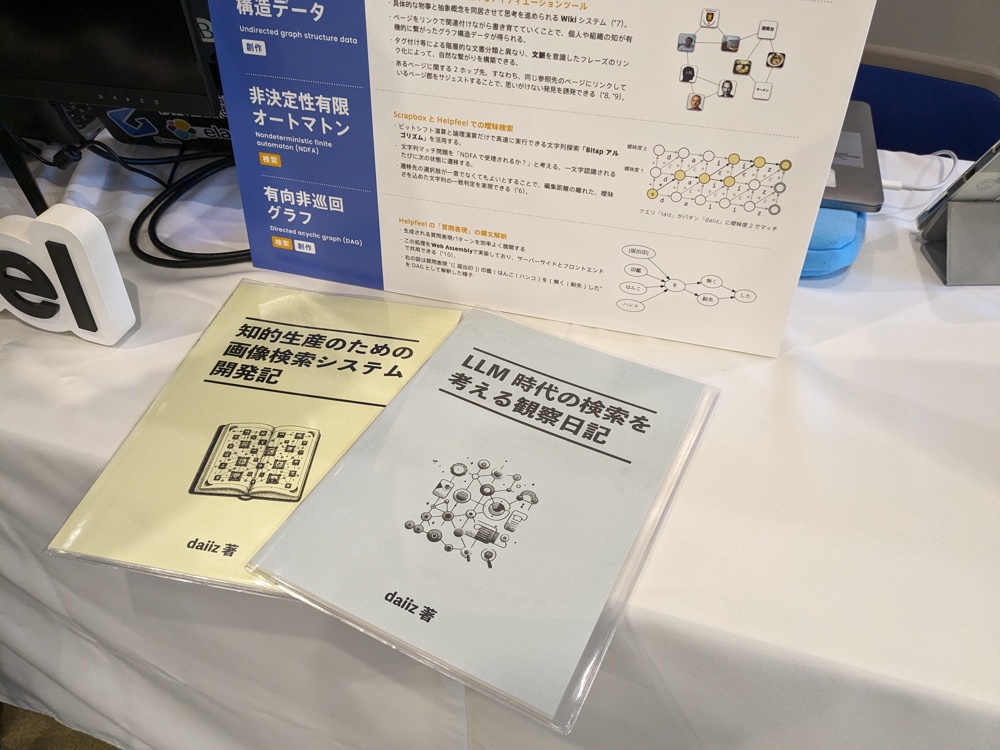

スポンサーブース

株式会社Helpfeelはプラチナスポンサーとして協賛しています

ブース設営完了

3階(受付通過して直進)でお待ちしています!

旅日記

移動

神戸三宮から神戸新交通ポートライナーで会場に向かう

無人運転!

海見れた

ピラミッド型の噴水

昼食

会場横のホテルのレストランでおでん定食を食べた

夕食

継続事前学習を教えてもらった